Op 1 juni kwam Kars Alfrink bij ons langs om een workshop te testen over 'Contestable AI'. Wij hadden geen idee wat we ons daarbij voor moesten stellen. Maar als Kars er is wordt het altijd interessant, dus kom maar op.

Gelukkig was hij bereid om uit te leggen wat we gingen doen en vooral waarom we dat gingen doen.

Kars is bezig met een PhD bij de TU Delft. "Ik kijk naar het gebruik van Artificial Intelligence (AI) in de publieke sector, en hoe je er voor kunt zorgen dat systemen aanvechtbaar zijn, contestable, in het Engels. En specifiek kijk ik naar de rol van design daarin."

Transparantie

"Toen ik begon met mijn onderzoek, heb ik onderzocht hoe je meer transparantie kunt aanbrengen in AI. Dus dat je beter kunt volgen wat er gebeurt in zo'n model. Maar gaandeweg kwam ik er achter dat transparantie niet genoeg is, maar dat je ook iets terug moet kunnen zeggen tegen de AI. Protest aantekenen tegen een beslissing, andere regels voorstellen, oneerlijkheden aanwijzen. Tegenspraak, contestability dus."

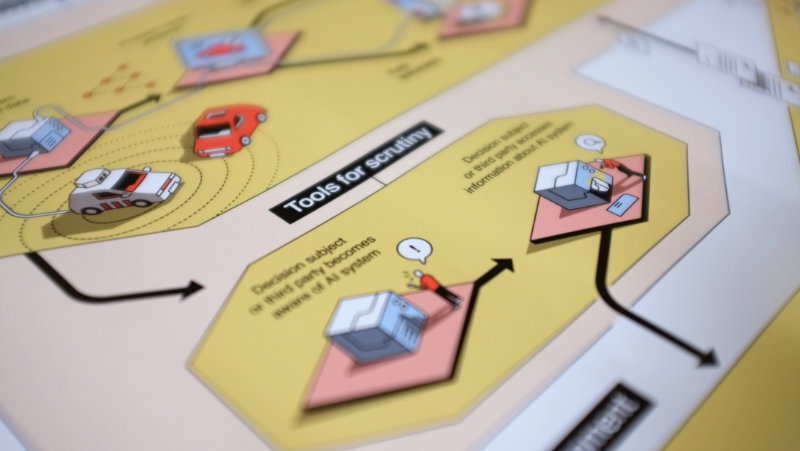

"In deze workshop gaan we een infographic gebruiken die ik heb gemaakt, met information design van Leon de Korte. Het is een vertaling van een ontwerpkader dat ik een tijdje terug heb gepubliceerd in een wetenschappelijk journal. Ik wil die kennis nu ook naar de praktijk brengen, vandaar die infographic. En dan is natuurlijk de vraag of het wat is..."

Een mooie poster

Kars lichtte de poster toe die hij heeft ontworpen. Daarop zie je allerlei verschillende rollen die mensen kunnen hebben als ze te maken krijgen met AI. Je kunt de plaat gebruiken om met elkaar te praten over die verschillende rollen en de situaties waar ze in voorkomen. En te bedenken waar je allemaal rekening mee moet houden.

"Ik wil kijken of mensen met mijn ontwerp aan de slag kunnen. En aan de andere kant heb ik dan wat inzicht om te praten over de onderliggende ideeën, ontwikkelingen en concepten. Of die inderdaad leiden tot nieuwe ideeën voor het ontwerpen van publieke AI-systemen."

Waarom is dat belangrijk?

"Intrinsiek is dat belangrijk omdat het bijdraagt aan de autonomie en de waardigheid van mensen die in aanraking komen met AI. En in de context van publiek bestuur wil je ook dat mensen in staat zijn om alternatieve manieren van leven vorm te geven buiten de staat. Omdat dat vervolgens kan leiden tot vernieuwing van de staat. Dat heet prefiguration. Als je menselijke vrijheid gaat indammen, dan beperk je die mogelijkheden heel erg, en dat beperkt dan vervolgens dan ook het vernieuwende vermogen van de samenleving. Dus daarom is het maatschappelijk waardevol."

Met z'n vieren kregen we de opdracht om te bedenken wat er allemaal komt kijken bij een AI die voorspellingen doet over (illegale) AirBnB-verhuur in Amsterdam. Aan de hand van de poster hebben we goede discussies gehad over op welke punten je allemaal moet letten, en waar we ingrijpmomenten konden inbouwen in het ontwerp.

Er kwamen boeiende problemen en dilemma's aan de orde. We snappen dankzij het overzicht op de poster veel beter hoe je rekening kunt houden met belangrijke publieke waarden. Zonder dat je op technisch gebied iets hoeft te snappen van hoe AI in elkaar zit. En dat is een grote opluchting!

En, is het wat?

Wij denken dat deze poster een heel goed stuk gereedschap gaat worden om beleids- en uitvoeringsmensen mee te laten denken over hoe AI ontworpen en ingezet kan worden. Hij is ook handig voor politici op allerlei niveau's. De poster is niet intimiderend, maar juist heel toegankelijk. En dat is fijn, want AI is te belangrijk en invloedrijk om exclusief over te laten aan mensen die de technische achtergronden tot in de puntjes snappen.

-------

Meer lezen?

We hebben Kars ook de vraag gesteld die op dit moment op ieders lippen brandt: gaat AI de wereld overnemen?

"Als je de media moet geloven wel. Daar is momenteel heel veel hype over. Het korte antwoord is denk ik 'nee.' Maar het lange antwoord is 'wat bedoelen we als we AI zeggen?' Want daar zit een hele wereld aan aannames achter. En daar zit de crux.

AI wordt nu geframed alsof het een soort autonome technologie is, die out of control is, en letterlijk de wereld over kán nemen. Maar tussen dat soort van toekomstbeelden en de realiteit zit een enorme kloof.

Sommige mensen hangen een idee aan dat je met de gigantisch grote modellen die nu gebruik worden in bepaalde toepassingen, generatieve AI enzo, dat daar op een gegeven moment een kwalitatief omslagpunt komt. Dat als je alles maar groter groter groter maakt, dat het dan niet alleen beter wordt in wat het nu kan, maar dat er een soort omslagpunt is, waardoor zo'n model opeens een soort van algemeen intelligent wordt.

En er is geen reden om aan te nemen dat dat ook werkelijk zo is. Filosofisch is dat heel interessant om over na te denken, maar praktisch gezien wordt AI eigenlijk ingezet om commerciële en politieke belangen te dienen. Dat is wat er eigenlijk schuilgaat achter die hype. En dat is heel schadelijk!

Want dat daardoor gebeurt is dat de aandacht wordt afgeleid van echte, huidige tekortkomingen en risico's van de AI die al daadwerkelijk bestaat. Bewust of onbewust. Ik vermoed dat zeker in het geval van een aantal mensen die bijvoorbeeld die open brief hebben ondertekend er ook absoluut een bewust motief achter zit: de aandacht afleiden van wat al bekend is aan schadelijke gevolgen van de huidige AI.

Je moet gewoon best wel ingevoerd zijn in de materie om überhaupt nog het onderscheid te maken tussen de verschillende perspectieven. En het vervelende is dat de meer kritische geluiden en de meer realistische geluiden toch iets minder makkelijk gehoord worden.

Dat heeft denk ik met de medialogica te maken: het is natuurlijk waanzinnig spannend en interessant om te schrijven over de existentiële gevaren van superintelligente systemen - Skynet etcetera. Dan hebben we het nog niet eens over populair-culturele gedeelde verbeeldingen die gelijk oppoppen bij mensen.

Dat maakt bezig zijn met waar ik nu mee bezig ben heel interessant, maar ook extra ingewikkeld. In het begin was het zo dat ik überhaupt het punt moest maken dat er gewoon risico's zitten aan deze techniek. Maar nu moet je niet alleen dát punt maken, je moet je niet alleen verhouden tot de techno-optimisten die zeggen 'het is allemaal geweldig, laten we het doen', maar ook dat nieuwe nieuwsfront van de existentiële gevaren. Dus dat is een uitdaging!"

Lekker dan. Wie moeten we dan volgen om goed op de hoogte te blijven van hoe het nou écht zit?

"Bij de TU Delft mensen als Roel Dobbe. En internationaal onder andere DAIR, het instituut dat is opgericht door Timnit Gebru. Zij werkte bij Google en schreef mee aan een vroege paper over de risico's van Large Language Models. Mede om die paper werd ze ontslagen... De nieuwsbrief van DAIR is heel interessant om te volgen. Zo zijn er nog wel een paar, maar deze zou ik bovenaan zetten.

Mocht je meer willen lezen over autonomie, prefiguration en publieke AI:

“A restatement of this problem is, then, the degree to which smart cities introducing architectures of efficiency reduces the opportunity for people to imagine or practice situations other than the one they are in.” Jewell, 2018, p. 221

“Similarly, the problem for attention I raise is not merely confined to practices of imagining alternatives but to the capacity for people to reconceptualise and materially enact those alternatives of ‘life as it is wished-for’ through, for example, prefigurative practices (Cooper 2017).” Jewell, 2018, p. 221

Het concept prefiguration komt uit Cooper, D. (2017). Prefiguring the State. Antipode, 49(2), 335–356.